DeepSeek 的技术原理主要基于深度学习,通过独特的模型架构、训练方法和优化策略,实现高效的语义理解与推理,其原理涉及模型架构设计、训练优化、推理加速等多个方面,具体如下:

1. 模型架构

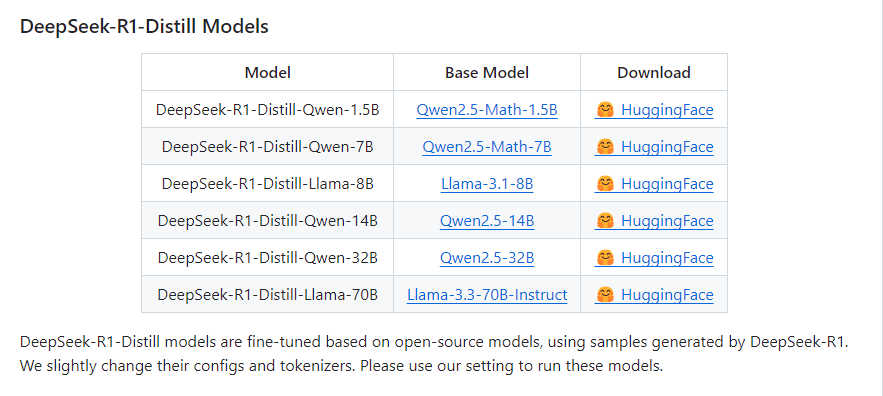

下载入口:所有模型均可通过 HuggingFace 平台下载,点击对应链接即可获取,方便开发者快速接入。

适用场景:因基于数学、通用基座模型蒸馏,适合需要高效推理、轻量化部署的场景(如小算力设备、对响应速度敏感的任务 ),同时保留了基础模型的核心能力。

使用英伟达显卡来部署 DeepSeek 模型,具有以下显著卖点:

高速并行计算:英伟达显卡基于 CUDA 架构,拥有大量的流处理器,能够并行处理大量计算任务。以 NVIDIA A100 为例,它拥有高达 80GB 的 HBM2e 显存, 单精度计算能力可达 624 TFLOPS,在处理 DeepSeek 模型的复杂计算任务,如大规模矩阵运算、张量操作时,能够快速完成前向传播和反向传播过程,大大缩短训练和推理时间 。

多卡协同加速:英伟达支持多卡并行计算,通过 NVLink 技术,多块显卡之间可以实现高速数据传输。在训练 DeepSeek 大型模型时,利用多卡并行计算,能线性提升计算效率,比如在 8 卡 NVIDIA A100 服务器上,相比单卡训练,速度可提升数倍,大幅减少模型训练周期。

深度学习框架支持:英伟达与主流深度学习框架如 PyTorch、TensorFlow 等深度集成,对 CUDA 和 cuDNN 进行了深度优化。在部署 DeepSeek 模型时,开发者可以直接利用这些框架对英伟达显卡的良好支持,无需重新开发底层计算逻辑,降低了开发难度和成本。例如,PyTorch 可以自动将计算任务分配到英伟达显卡上,充分利用其计算资源。

丰富的工具和库:英伟达提供了一系列用于深度学习开发和优化的工具和库,如 Nsight Systems 和 Nsight Compute,帮助开发者进行性能分析和调试。此外,cuDNN 库针对神经网络中的常见操作,如卷积、池化等,进行了高度优化,能显著提升 DeepSeek 模型的运行效率。

工业级品质:英伟达的专业显卡,如 Tesla 系列,经过严格的测试和验证,具备高可靠性和稳定性。在长时间、大规模的模型部署和运行过程中,能够持续稳定地提供计算服务,减少因硬件故障导致的服务中断风险,保障 DeepSeek 模型在生产环境中的可靠运行。

技术支持完善:英伟达拥有庞大的技术支持团队和丰富的技术文档,开发者在使用英伟达显卡部署 DeepSeek 模型时,遇到任何技术问题,都可以通过官方论坛、技术支持热线等渠道获得及时的帮助和解决方案。

广泛的硬件兼容性:英伟达显卡在市场上应用广泛,与大多数主流服务器硬件兼容,无论是戴尔、惠普等品牌的服务器,还是自定义搭建的服务器平台,都能方便地集成英伟达显卡,便于在不同的硬件环境中部署 DeepSeek 模型。

灵活的扩展能力:当业务需求增长,对计算资源的要求提高时,可以方便地添加英伟达显卡来扩展计算能力。同时,英伟达不断推出新的显卡产品,性能逐步提升,开发者可以根据实际需求灵活选择升级显卡,保证 DeepSeek 模型始终运行在高效的硬件环境中。

使用华为推理卡部署模型,有以下突出的卖点:

技术安全可靠:华为推理卡是国产芯片技术的代表,从底层硬件到上层软件栈,很多关键技术都实现了自主研发 。在当前复杂的国际环境下,对于政府、金融、能源等对信息安全要求极高的行业,使用华为推理卡部署 DeepSeek 模型,能有效避免潜在的供应链风险,确保数据和业务的安全性。

适配国内生态:积极适配国内的操作系统(如麒麟操作系统、统信操作系统等)、数据库等基础软件设施,与国内众多的软件开发商建立了良好的生态合作关系。这使得在国内的数字化转型项目中,使用华为推理卡部署模型,能够更好地融入整体的国产信息技术生态体系,减少兼容性问题。

高效的 AI 加速:华为推理卡(如昇腾 310 系列 )针对深度学习推理场景进行了深度优化,采用了达芬奇架构,具备强大的 AI 计算能力。在图像识别、自然语言处理等推理任务中,能够快速完成计算,对于 DeepSeek 模型的推理,能实现高效的响应,满足实时性要求较高的业务场景,如智能客服、智能写作辅助等。

低功耗高性能:在提供强大推理性能的同时,华为推理卡注重功耗控制。相比一些同类型的推理卡,能以较低的功耗实现相近甚至更高的推理效率,这对于数据中心大规模部署模型来说,可以有效降低运营成本,减少散热压力,提升整体的能源利用效率。

一站式开发平台:华为提供了全栈式的 AI 开发平台昇腾 AI,涵盖了开发框架(MindSpore)、工具链、模型库等。开发者在使用华为推理卡部署 DeepSeek 模型时,可以利用 MindSpore 框架灵活的编程范式,以及丰富的开发工具和模型优化功能,加速模型的部署和优化过程,降低开发门槛。

完善的技术支持:华为拥有专业的技术支持团队,为开发者提供从前期咨询、开发测试到后期运维的全方位服务。无论是在模型适配、性能调优还是故障排除等方面,开发者都能获得及时、有效的技术支持,保障模型部署和运行的顺利进行。

产学研合作:华为积极与国内高校、科研机构开展产学研合作,共同推动 AI 技术的发展和人才培养。开发者在使用华为推理卡部署模型时,可以获得丰富的学术资源和研究成果支持,同时也为高校和科研机构的研究成果转化提供了实践平台。

生态伙伴合作:华为围绕昇腾 AI 构建了庞大的生态伙伴体系,众多软件开发商、系统集成商基于华为推理卡开发了丰富的行业应用解决方案。这使得开发者在部署 DeepSeek 模型时,可以借鉴和复用生态伙伴的成功经验和方案,加速业务落地,拓展应用场景。

“产品 + 软件部署打包方案” 的核心卖点,在于解决用户从 “采购产品” 到 “能用、用好” 全流程的痛点,将硬件产品与软件部署服务深度整合,为用户提供 “省心、高效、可靠” 的一站式解决方案